미국주식 투자자로 성장주 가치투자라는 모토를 가지고 있습니다.

성장주 가치투자란 성장하는 기업을 적절한 가격에 매수하여 장기투자를 하는 것입니다.

이를 통해

수시로 시세를 확인하며 밤에 잠을 설치는 투자가 아니라

개인 수준에서 철저한 기업분석을 통해 매수를 하고 마음 편히 장기 보유하는 것을 추구합니다.

워렌버핏과 찰리멍거, 피터린치의 투자법에서 영감을 받았습니다.

안녕하십니까

선생님지킴이 파이팅쌤입니다!

오늘의 주제는

NVDA(엔비디아) 26회계연도 3분기 실적 완벽 분석

및 어닝콜 핵심 내용

_Feat. 엔비디아는 문제없다

입니다.

목차

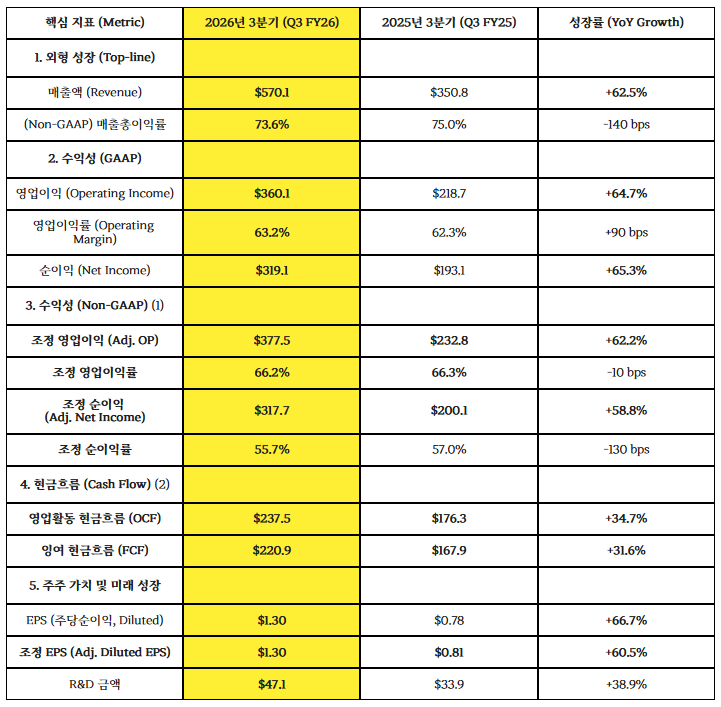

1. NVDA 26회계연도 3분기 핵심성장지표

2. NADA 26회계연도 3분기 사업부문별 지표

3. 어닝콜 핵심 내용

4. 어닝콜 Q&A 전문

5. 핵심 인사이트

1. NVDA 26회계연도 3분기 핵심성장지표

데이터센터가 주도한 초고속 성장

전체 매출의 약 90%를 차지하는 데이터센터(Data Center) 매출이

$512억 달러로 전년 대비 66% 급증했습니다.

이는 'Blackwell' 아키텍처에 대한 강력한 수요와 AI 모델의 복잡성 증가에 기인합니다.

네트워킹 부문의 폭발

데이터센터 내 네트워킹 매출은 $82억 달러로 전년 대비

162% 폭증했습니다.

이는 AI 클러스터 구축을 위해

NVLink와 같은 고속 연결 기술이 필수재가 되었음을 보여줍니다.

압도적인 수익성 (마진 63%)

제조업 기반의 하드웨어 기업임에도 불구하고

영업이익률이 63.1%라는

경이적인 수준을 기록했습니다.

이는 엔비디아가 단순한 칩 제조사가 아니라

'AI 플랫폼'을 독점 공급하는 소프트웨어 기업에 가까운

경제적 해자(Moat)를 가졌음을 증명합니다.

마진 소폭 하락의 이유

매출총이익률은 74.6%에서 73.4%로 소폭 하락했습니다.

보고서는 이를 "Hopper(기존) 시스템에서 Blackwell(신규) 시스템으로의 전환 과정" 때문이라고 설명했습니다.

초기 수율 안정화 비용 등이 반영된 것으로 보입니다.

보통 기술 기업들은 주식 보상 비용(SBC) 등을 제외하여 Non-GAAP 이익을 부풀립니다.

하지만 이번 분기 엔비디아는 특이하게도

GAAP 순이익($319억)이 Non-GAAP 순이익($318억)보다 높습니다.

이번 분기에 '기타 수익(Other Income)'으로

약 13.5억 달러의 투자 평가 이익이 발생했기 때문입니다.

엔비디아가 투자한 비상장/상장 기업들의 가치가 급등하면서,

주식 보상 비용(약 16.6억 달러)을 상쇄하고도 남을 만큼의 이익을 안겨주었습니다.

이는 엔비디아가 본업(반도체)뿐만 아니라,

AI 생태계 투자(NVIDIA Ventures 등)에서도 막대한 수익을 거두기 시작했음을 의미합니다.

엔비디아 생태계의 확장이 금융 수익으로 돌아오고 있습니다.

분기 FCF $220억 달러

단 3개월 만에 220억 달러(약 30조 원)의 현금을 남겼습니다.

이는 전년 동기 대비 32% 증가한 수치입니다.

FCF 마진율(매출 대비 FCF)이 여전히 **38.7%**에 달해,

제조업이라기보다는 소프트웨어 기업 수준의 현금 창출력을 유지하고 있습니다.

Non-GAAP 총이익률 하락 (75.0% - 73.6%)

전년 동기 대비 1.4%p 하락했습니다.

이는 부정적인 신호라기보다 '제품 전환기(Transition)'의 비용입니다.

기존 Hopper(H100/H200)에서 차세대 Blackwell(B200/GB200)로 넘어가는 과정에서

초기 수율 안정화 비용과 복잡한 제조 공정 비용이 반영되었습니다.

회사는 4분기 가이던스로 다시 75.0% 수준의 마진 회복을 예고했습니다.

즉, Blackwell 양산이 안정화되면 마진은 다시 정상 궤도(75%대)로 복귀할 것입니다.

R&D 비용은 39% 증가했지만, 매출은 62% 증가했습니다.

이로 인해 조정 영업이익률은 66.2%라는 경이적인 수준을 유지했습니다.

100원을 팔면 운영비 다 쓰고 66원이 남는다는 뜻입니다.

경쟁사들이 따라올 수 없는 압도적인 '규모의 경제'가 작동하고 있습니다.

엔비디아는 차세대 칩(Blackwell)으로의 전환기임에도 불구하고

폭발적인 성장과 수익성을 유지하고 있습니다.

R&D 투자를 39%나 늘렸음에도 영업이익률이 상승했다는 것은

매출 성장이 비용 증가를 압도하는 강력한 레버리지 효과가 작동하고 있음을 의미합니다.

2. NADA 26회계연도 3분기 사업부문별 지표

3. 어닝콜 핵심 내용

매출 폭발적 성장

3분기 매출 570억 달러(YoY +62%),

데이터센터 매출 510억 달러(YoY +66%)로 사상 최대 실적 기록.

가이던스

4분기 매출 전망 650억 달러(+/- 2%),

총마진율(Gross Margin)은 70% 중반대(Mid-70s) 유지를 목표로 함.

미래 매출 가시성

Blackwell(블랙웰)과 Rubin(루빈) 플랫폼을 통해

올해 초부터 2026년 말까지 5,000억 달러(약 700조 원) 규모의 매출 가시성 확보.

핵심 성장 동력 (3대 전환)

가속 컴퓨팅 (Accelerated Computing)

무어의 법칙 둔화로 인한 필수적 전환.

생성형 AI (Generative AI)

기존 머신러닝을 대체하며 검색, 추천 시스템 혁신.

에이전트 AI (Agentic AI)

스스로 추론하고 도구를 사용하는 새로운 AI의 부상(예: 코딩 비서, 자율주행 등)이

차세대 성장을 주도

제품 및 공급망

Blackwell & Rubin

Blackwell 수요가 공급을 초과하며 클라우드 물량은 매진(Sold out).

차세대 Rubin 플랫폼은 2026년 하반기 램프업 예정.

공급망

공급망 관리(TSMC, 메모리 등)가 잘 되고 있으나 수요가 워낙 강력함.

중국 시장

H20 칩 매출은 약 5,000만 달러로 지정학적 이슈 및 경쟁 심화로 인해 부진.

OpenAI & Anthropic

단순 협력을 넘어 지분 투자를 포함한 전략적 파트너십 체결.

Anthropic이 처음으로 엔비디아 아키텍처 채택.

확장성

엔비디아는 모든 AI 모델(프론티어 모델부터 과학 모델까지)을

실행할 수 있는 유일한 플랫폼임을 강조.

4. 어닝콜 Q&A 전문

_아래의 어닝콜 Q&A 내용 중 이해가 되지 않는 부분은 Gemini, Chat GPT 같은 생성형 AI에게 물어보면서

이해를 한다면 추후 기업 분석에도 큰 도움이 될 것으로 생각됩니다.

Operator 0:29:06 운영자님, 질문 접수를 받아주시겠습니까? 감사합니다. 질문을 하시려면 전화기 키패드의 별표(*)와 1번을 눌러주시기 바랍니다.

Operator 0:29:19 잠시 질문자 목록을 정리하겠습니다. 질문은 한 분당 하나로 제한해 주시기 바랍니다. 감사합니다. 첫 번째 질문은 모건 스탠리의 Joseph Moore 님입니다. 연결되었습니다.

Joseph Moore (Morgan Stanley) 0:29:34 네, 감사합니다. 업데이트를 좀 부탁드리고 싶은데요. 지난 GTC에서 2025년과 2026년에 걸쳐 Blackwell과 Rubin으로 5,000억 달러의 매출이 발생할 것이라고 말씀하셨습니다. 당시 그중 1,500억 달러는 이미 출하되었다고 하셨고요. 분기가 마무리된 지금, 향후 14개월 정도 동안 3,500억 달러가 남았다는 그 전반적인 틀이 여전히 유효한지 궁금합니다. 그 기간 동안의 모든 수요를 아직 다 확인하신 건 아니겠지만, 앞으로 그 수치보다 상향될 가능성이 있는지요?

Colette Kress (EVP and CFO) 0:30:05 네, 감사합니다 조. 제가 먼저 답변드리겠습니다. 네, 맞습니다. 우리는 5,000억 달러 전망치를 향해 나아가고 있으며, 몇 개 분기를 마친 현재 2026년 말까지 남은 분기들에 대해서도 순항하고 있습니다. 그 숫자는 더 커질 것이며, 2026 회계연도까지 출하 가능한 추가적인 컴퓨팅 수요를 달성할 수 있을 것이라 확신합니다. 이번 분기에 500억 달러를 출하했지만, 추가 주문을 받지 않을 것이라고 말한다면 거짓말이겠죠. 예를 들어, 오늘 발표한 사우디아라비아(KSA)와의 계약만 해도 3년 동안 40만~60만 개의 GPU가 추가되는 것입니다. Anthropic 건도 새로운 소식이고요. 우리가 발표했던 5,000억 달러 외에 추가적인 기회가 분명히 존재합니다.

Operator 0:31:09 다음 질문은 Cantor Fitzgerald의 C.J. Muse 님입니다.

Operator 0:31:20 연결되었습니다.

CJ Muse (Cantor Fitzgerald) 0:31:21 네, 안녕하세요. 질문 받아주셔서 감사합니다. AI 인프라 구축의 규모와 그러한 계획을 위한 자금 조달 능력, 그리고 ROI(투자수익률)에 대해 시장의 우려가 상당히 큽니다. 하지만 동시에 엔비디아는 "매진(sold out)"되었다고 말합니다. 설치된 모든 GPU가 사용되고 있다고요. AI 세계는 아직 B300의 엄청난 혜택을 보지도 못했고, Rubin은 말할 것도 없는데 Gemini 3가 방금 Grok 5 출시 임박을 알렸습니다. 질문은 이것입니다. 이러한 배경을 볼 때, 향후 12~18개월 내에 공급이 수요를 따라잡을 수 있는 현실적인 경로가 있다고 보십니까? 아니면 그 기간을 넘어설 것이라고 보십니까?

Jensen Huang (CEO) 0:31:59 아시다시피, 우리는 공급망 계획을 정말 잘 해왔습니다. 엔비디아의 공급망은 기본적으로 전 세계 모든 기술 회사를 포함합니다. TSMC와 패키징 파트너, 메모리 벤더 및 파트너, 그리고 모든 시스템 ODM들이 우리와 함께 계획을 아주 잘 세워왔습니다. 우리는 큰 한 해를 준비하고 있었습니다. 우리는 제가 방금 말씀드린 세 가지 전환을 꽤 오랫동안 목격해 왔습니다. 바로 범용 컴퓨팅에서 가속 컴퓨팅으로의 전환입니다. AI가 단순히 '에이전트 AI(Agentic AI)'뿐만 아니라, '생성형 AI'가 하이퍼스케일러들이 과거 CPU로 하던 작업을 변화시키고 있다는 점을 인식하는 것이 정말 중요합니다. 생성형 AI는 그들이 검색, 추천 시스템, 광고 추천 및 타겟팅을 옮겨올 수 있게 만들었습니다. 이 모든 것이 생성형 AI로 이동했고 여전히 전환 중입니다. 데이터 처리를 위해 엔비디아 GPU를 설치했든, 추천 시스템을 위해 생성형 AI용으로 설치했든, 아니면 사람들이 AI를 생각할 때 떠올리는 에이전트 챗봇 같은 것을 위해 구축하든, 이 모든 애플리케이션은 엔비디아 GPU로 가속화됩니다. 전체 지출을 볼 때, 이 각각의 레이어(layer)를 생각하는 것이 중요합니다. 모두 성장하고 있습니다. 서로 관련되어 있지만 같지는 않습니다. 멋진 점은 이들 모두가 엔비디아 GPU에서 실행된다는 것입니다. 동시에 AI 모델의 품질이 믿을 수 없을 정도로 향상되고 있기 때문에, 다양한 사용 사례에서의 채택이 늘고 있습니다. 코드 지원(Code assistance)의 경우 엔비디아도 꽤 집중적으로 사용하고 있고 우리만 그런 것이 아닙니다. Cursor, Claude Code, OpenAI의 Codex, GitHub Copilot의 조합은 역사상 가장 빠르게 성장하는 애플리케이션입니다. 이건 단순히 소프트웨어 엔지니어만 사용하는 게 아닙니다. 소위 '바이브 코딩(vibe coding)' 때문에 기업 내 엔지니어, 마케터, 공급망 기획자 등 모두가 사용합니다. 이건 단지 하나의 예일 뿐이며, 오픈 에비던스(Open Evidence)의 헬스케어 분야나 런웨이(Runway)의 디지털 비디오 편집 등 목록은 계속됩니다. 생성형 AI와 에이전트 AI를 활용하는 정말 흥미로운 스타트업의 수가 급격히 늘고 있습니다. 말할 것도 없이, 우리 모두가 AI를 훨씬 더 많이 사용하고 있습니다. 이러한 모든 기하급수적 성장들이 동시에 일어나고 있습니다. 오늘만 해도 데미스(Demis Hassabis, 구글 딥마인드 CEO 추정)에게서 문자를 받았는데, 사전 학습(Pre-training)과 사후 학습(Post-training)의 법칙이 여전히 건재하다고 하더군요. Gemini 3는 스케일링 법칙을 활용해 품질 성능과 모델 성능에서 비약적인 도약을 이뤘습니다. 우리는 이 모든 지수함수적 성장이 동시에 달리는 것을 보고 있습니다. 저는 항상 제1원칙(First principles)으로 돌아가 제가 앞서 언급한 각 역학 관계에서 무슨 일이 일어나고 있는지 생각합니다. 범용 컴퓨팅에서 가속 컴퓨팅으로의 전환, 고전적인 머신러닝을 대체하는 생성형 AI, 그리고 물론 완전히 새로운 카테고리인 에이전트 AI까지 말입니다.

Operator 0:35:35 다음 질문은 Bank of America Securities의 Vivek Arya 님입니다. 연결되었습니다.

Vivek Arya (Bank of America Securities) 0:35:47 질문 기회를 주셔서 감사합니다. 말씀하신 5,000억 달러 수치에 기가와트(GW) 당 엔비디아의 콘텐츠(매출 비중)를 어떻게 가정하고 계신지 궁금합니다. 왜냐하면 기가와트당 콘텐츠가 적게는 250억 달러에서 많게는 300~400억 달러까지라는 이야기를 들었기 때문입니다. 그 5,000억 달러 숫자에 포함된 전력 및 기가와트당 달러 가정이 궁금합니다. 그리고 장기적으로 젠슨 CEO님, 2030년까지 데이터센터 규모가 3조~4조 달러에 달할 것이라고 언급하셨는데, 그중 얼마나 벤더 파이낸싱(Vendor financing)이 필요할 것이며, 어느 정도가 대형 고객이나 정부, 기업들의 현금 흐름으로 감당 가능하다고 보십니까? 감사합니다.

Jensen Huang (CEO) 0:36:31 Ampere에서 Hopper로, Hopper에서 Blackwell로, Blackwell에서 Rubin으로 세대가 바뀔 때마다 데이터센터 내 우리의 비중은 증가합니다. Hopper 세대에는 아마 20대 중반(20~25%) 정도였을 겁니다. Blackwell 세대, 특히 Grace Blackwell은 30 전후, 대략 30% 정도일 것입니다. Rubin은 그보다 더 높을 것입니다. 이 각 세대마다 속도 향상은 'X배(X factor)' 수준입니다. 따라서 고객의 총소유비용(TCO)은 X배로 개선됩니다. 가장 중요한 것은, 결국 전력은 1기가와트뿐이라는 점입니다. 1기가와트 데이터센터는 1기가와트의 전력을 씁니다. 따라서 와트당 성능(Performance per watt), 아키텍처의 효율성이 엄청나게 중요합니다. 아키텍처의 효율성은 무식하게 밀어붙여서(brute force) 되는 게 아닙니다. 그럴 수가 없죠. 그 1기가와트, 즉 와트당 성능은 귀사의 매출로 직결됩니다. 절대적으로 직결됩니다. 이것이 바로 지금 올바른 아키텍처를 선택하는 것이 그토록 중요한 이유입니다. 세상에는 낭비할 수 있는 잉여 자원이 없습니다. 우리는 전체 스택, 프레임워크와 모델, 전체 데이터센터, 심지어 전력과 냉각까지 전체 공급망 생태계에 걸쳐 최적화하는 '공동 설계(co-design)'라는 개념을 사용합니다. 매 세대마다 우리의 경제적 기여도는 더 커질 것입니다. 우리가 전달하는 가치는 더 커질 것입니다. 가장 중요한 것은 우리의 와트당 에너지 효율이 매 세대마다 놀라울 것이라는 점입니다. 지속적인 성장과 관련하여, 고객들의 자금 조달은 그들에게 달려 있습니다. 우리는 꽤 오랫동안 성장할 기회를 보고 있습니다. 기억해 주십시오. 오늘날 대부분의 관심은 하이퍼스케일러(대형 클라우드 업체)에 집중되어 있습니다. 하이퍼스케일러에 대해 정말 오해받는 부분 중 하나는, 엔비디아 GPU에 대한 투자가 단순히 범용 컴퓨팅 대비 규모, 속도, 비용을 개선하는 것(이것이 첫 번째 이유입니다, 무어의 법칙이 둔화되었으니까요) 뿐만이 아니라는 것입니다. 무어의 법칙은 비용을 낮추는 것, 컴퓨팅 비용의 엄청난 디플레이션에 관한 것이었습니다. 그게 느려졌습니다. 그래서 비용을 계속 낮추기 위해 새로운 접근 방식이 필요한데, 엔비디아 GPU 컴퓨팅으로 가는 것이 최선의 방법입니다. 두 번째는 현재 비즈니스 모델에서의 매출 증대입니다. 추천 시스템은 전 세계 하이퍼스케일러를 움직입니다. 숏폼 비디오를 보든, 책을 추천하든, 장바구니에 담을 다음 물건을 추천하든, 광고나 뉴스를 추천하든, 모든 것은 추천 시스템에 달려 있습니다. 인터넷에는 수조 개의 콘텐츠가 있습니다. 정말 정교한 추천 시스템 없이는 그들이 어떻게 당신의 작은 화면에 무엇을 띄울지 알아낼 수 있겠습니까? 이것이 생성형 AI로 넘어갔습니다. 제가 방금 말씀드린 이 두 가지, 수천억 달러의 CapEx(설비투자)가 투자되어야 하는 이 부분은 전적으로 현금 흐름(Cash flow)으로 충당됩니다. 따라서 그 위에 있는 것이 바로 에이전트 AI입니다. 이것은 순수한 신규(net new) 소비이자 신규 애플리케이션입니다. 제가 앞서 언급한 애플리케이션들 중 일부는 역사상 가장 빠르게 성장하고 있습니다. 단순히 CapEx 투자 관점에서만 보지 않고 수면 아래에서 실제로 무슨 일이 일어나는지, 즉 이 세 가지 역학 관계를 이해하기 시작하면 상황이 보일 것입니다. 마지막으로, 우리는 방금 미국 CSP(클라우드 서비스 제공자)들에 대해 이야기했습니다. 각 국가는 자체 인프라에 자금을 댈 것입니다. 여러 국가가 있고, 여러 산업이 있습니다. 전 세계 대부분의 산업은 아직 에이전트 AI에 본격적으로 관여하지 않았지만, 곧 그렇게 될 것입니다. 자율주행차 회사든, 공장을 위한 물리적 AI용 디지털 트윈이든, 전 세계에 지어지고 있는 수많은 공장과 창고들, 그리고 신약 개발 가속화를 위해 투자를 받고 있는 수많은 디지털 바이오 스타트업들 등, 우리가 협력하고 있는 기업들의 이름을 아실 겁니다. 그 모든 다양한 산업들이 이제 참여하고 있으며, 그들은 자체적으로 자금을 조달할 것입니다. 하이퍼스케일러만 미래를 구축하는 주체로 보지 마십시오. 세상을 봐야 합니다. 모든 다양한 산업을 봐야 합니다. 엔터프라이즈 컴퓨팅은 그들 자신의 산업에 자금을 댈 것입니다.

Operator 0:41:55 다음 질문은 Melius의 Ben Reitzes 님입니다. 연결되었습니다.

Ben Reitzes (Melius) 0:42:05 네, 감사합니다. 젠슨 님, 현금(Cash)에 대해 여쭤보고 싶습니다. 5,000억 달러 이야기가 나왔는데, 향후 몇 년간 잉여 현금 흐름(Free Cash Flow)만 5,000억 달러 정도 창출하실 수도 있을 것 같습니다. 그 현금에 대한 계획은 무엇입니까? 자사주 매입(buyback) 대비 생태계 투자 비중은 어떻게 됩니까? 생태계 투자는 어떻게 보십니까? Anthropic이나 OpenAI 같은 거래가 어떻게 작동하는지, 그리고 그런 투자를 하는 기준이 무엇인지에 대해 외부에 혼란이 좀 있는 것 같습니다. 감사합니다.

Jensen Huang (CEO) 0:42:38 네, 질문 감사합니다. 물론, 성장을 위한 자금으로 현금을 사용합니다. 우리가 이야기하는 규모로 성장하고, 엔비디아가 가진 공급망의 깊이와 넓이, 연결성을 가진 회사는 없습니다. 우리의 전체 고객 기반이 우리를 신뢰할 수 있는 이유는 우리가 정말 탄력적인 공급망을 확보했고, 그들을 지원할 대차대조표(balance sheet)를 가지고 있기 때문입니다. 우리가 구매를 할 때, 공급업체들은 우리를 전적으로 신뢰합니다(take it to the bank). 우리가 예측을 하고 그들과 계획을 세울 때, 우리의 대차대조표 때문에 그들은 우리를 진지하게 받아들입니다. 우리는 구매 물량(offtake)을 지어내지 않습니다. 우리는 우리의 구매 물량이 얼마인지 압니다. 그들이 우리와 수년 동안 계획을 세워왔기 때문에 우리의 평판과 신뢰도는 엄청납니다. 그러한 수준의 성장과 속도, 규모를 감당하려면 정말 강력한 대차대조표가 필요합니다. 그게 첫 번째입니다. 두 번째로, 물론 우리는 자사주 매입을 계속할 것입니다. 계속할 겁니다. 투자와 관련해서는, 이건 정말 정말 중요한 작업입니다. 지금까지 우리가 한 모든 투자는 CUDA의 도달 범위를 넓히고 생태계를 확장하는 것과 관련이 있습니다. OpenAI와의 투자를 보면, 물론 2016년부터 이어온 관계입니다. 제가 OpenAI에 사상 최초의 AI 슈퍼컴퓨터를 전달했었죠. 우리는 그 이후로 가깝고 멋진 관계를 유지해 왔습니다. 오늘날 OpenAI가 하는 모든 것은 엔비디아에서 실행됩니다. 훈련이든 추론이든 그들이 배포하는 모든 클라우드는 엔비디아를 실행하며, 우리는 그들과 일하는 것을 좋아합니다. 그들과의 파트너십은 기술적 관점에서 더 깊이 협력하여 그들의 가속화된 성장을 지원하기 위함입니다. 이 회사는 엄청나게 빠르게 성장하고 있습니다. 언론에 나오는 말만 보지 마십시오. OpenAI에 연결된 모든 생태계 파트너와 개발자들을 보십시오. 그들 모두가 소비를 주도하고 있습니다. 생성되는 AI의 품질은 1년 전보다 엄청나게 향상되었습니다. 응답의 품질이 뛰어납니다. 우리는 공동 개발을 통해 깊은 파트너십을 맺고, 생태계를 확장하며, 그들의 성장을 지원하기 위해 OpenAI에 투자합니다. 물론 우리 회사의 지분을 내주는 대신, 우리는 그들 회사의 지분을 얻습니다. 우리는 한 세대에 한 번 나올까 말까 한 가장 중요한 회사 중 하나, 우리가 지분을 가진 그 회사에 투자했습니다. 저는 그 투자가 엄청난 수익으로 돌아올 것이라고 전적으로 기대합니다. 이제 Anthropic의 경우, Anthropic이 엔비디아 아키텍처를 도입하는 것은 이번이 처음입니다. 엔비디아 아키텍처에 처음으로 합류하는 Anthropic은 총 사용자 수 기준으로 세계에서 두 번째로 성공적인 AI입니다. 기업(Enterprise) 시장에서 그들은 믿을 수 없을 정도로 잘하고 있습니다. Claude Code도, Claude도 전 세계 기업에서 매우 잘 나가고 있습니다. 이제 우리는 그들과 깊은 파트너십을 맺고 Claude를 엔비디아 플랫폼으로 가져올 기회를 갖게 되었습니다. 지금 우리가 가진 게 무엇입니까? 한 걸음 물러서서 보면, 엔비디아의 아키텍처, 엔비디아의 플랫폼은 모든 AI 모델을 실행하는 세계 유일의 플랫폼입니다. 우리는 OpenAI를 실행합니다. Anthropic을 실행합니다. Elon Musk 및 xAI와의 깊은 파트너십 덕분에 xAI를 실행합니다. 우리는 그 기회를 사우디아라비아(KSA)로 가져와 Humane이 xAI를 호스팅 할 수 있는 기회도 만들 수 있었습니다. 우리는 xAI를 실행하고, Gemini를 실행하고, Thinking Machines를 실행합니다. 또 뭘 실행하죠? 우리는 그들 모두를 실행합니다. 뿐만 아니라 과학 모델, 생물학 모델, DNA 모델, 유전자 모델, 화학 모델 등 전 세계의 다양한 분야를 실행합니다. 세상이 사용하는 건 인지 AI(cognitive AI)뿐만이 아닙니다. AI는 모든 단일 산업에 영향을 미치고 있습니다. 우리는 우리가 하는 생태계 투자를 통해 세계에서 가장 훌륭하고 뛰어난 기업들과 기술적으로 깊이 파트너십을 맺을 능력이 있습니다. 우리는 생태계의 도달 범위를 확장하고 있으며, 매우 성공적인 회사가 될 기업, 종종 한 세대에 한 번 나올 기업의 지분과 투자를 얻고 있습니다. 이것이 우리의 투자 논리(thesis)입니다.

Operator 0:47:52 다음 질문은 Goldman Sachs의 Jim Schneider 님입니다. 연결되었습니다.

Jim Schneider (Goldman Sachs) 0:48:02 안녕하세요. 질문 받아주셔서 감사합니다. 과거에 출하량의 약 40%가 AI 추론(Inference)과 관련되어 있다고 말씀하셨습니다. 내년을 내다보실 때, 예를 들어 1년 후 이 비율이 어디까지 갈 것으로 예상하십니까? 그리고 내년에 출시 예정인 Rubin CPX 제품에 대해 좀 더 설명해 주시고 맥락을 짚어주실 수 있을까요? 전체 TAM(총 유효 시장)에서 이 제품이 얼마나 차지할 것으로 보시며, 구체적인 타겟 고객 애플리케이션은 무엇인지 말씀해 주십시오. 감사합니다.

Jensen Huang (CEO) 0:48:34 CPX는 긴 문맥(long-context) 유형의 워크로드 생성을 위해 설계되었습니다. 긴 문맥이란, 기본적으로 답을 생성하기 전에 많이 읽어야 하는 것을 말합니다. 수많은 PDF일 수도 있고, 많은 비디오를 보거나 3D 이미지를 연구하는 것 등일 수 있습니다. 문맥을 흡수해야 하죠. CPX는 이런 긴 문맥 유형의 워크로드를 위해 설계되었습니다. 달러당 성능이 훌륭하고 와트당 성능도 뛰어납니다. 그러고 보니 질문의 앞부분을 잊어버렸네요. 아, 추론이요. 네. 동시에 확장되고 있는 세 가지 스케일링 법칙이 있습니다. 첫 번째 스케일링 법칙인 사전 학습(pretraining)은 계속해서 매우 효과적입니다. 두 번째는 사후 학습(post-training)입니다. 사후 학습은 AI가 문제를 쪼개서 단계별로 해결하는 능력을 향상시키는 놀라운 알고리즘들을 발견했습니다. 사후 학습은 기하급수적으로 확장되고 있습니다. 기본적으로 모델에 더 많은 컴퓨팅을 적용할수록 더 똑똑해지고 지능화됩니다. 그리고 세 번째가 추론(inference)입니다. 추론은 '생각의 사슬(chain of thought)'과 추론 능력 때문에, AI가 본질적으로 답하기 전에 읽고 생각하게 됩니다. 이 세 가지로 인해 필요한 연산량은 완전히 기하급수적으로 늘어났습니다. 어떤 시점에 정확히 비율이 얼마가 될지, 누가 될지 알기는 어렵습니다. 물론 우리의 희망은 추론이 시장의 매우 큰 부분이 되는 것입니다. 추론이 크다는 것은 사람들이 더 많은 애플리케이션에서 더 빈번하게 사용하고 있다는 뜻이니까요. 우리는 모두 추론 시장이 매우 커지기를 바라야 합니다. 이 부분에서 Grace Blackwell은 전 세계 어떤 것보다 한 차원 더 낫고 진보되어 있습니다. 두 번째로 좋은 플랫폼은 H200입니다. GB300, GB200, 그리고 GB300이 NVLink 72라는 우리가 달성한 스케일업(scale-up) 네트워크 덕분에, 그리고 Colette가 언급한 세미애널리시스(SemiAnalysis) 벤치마크(역대 최대 단일 추론 벤치마크)에서 보셨듯이, GB200 NVLink 72는 10배, 10~15배 더 높은 성능을 보여줍니다. 이는 엄청난 도약입니다. 누군가 이를 따라잡으려면 오랜 시간이 걸릴 것입니다. 우리의 리더십은 확실히 수년간 지속될 것입니다. 네, 저는 추론이 아주 큰 시장이 되기를 희망합니다. 추론 분야에서 우리의 리더십은 탁월합니다.

Operator 0:51:20 (Timothy Arcury 부분 시작) 다음 질문은 UBS의 Timothy Arcury 님입니다. 연결되었습니다. 감사합니다. 젠슨 님, 많은 고객들이 '미터기 뒤(behind-the-meter, 전력망을 거치지 않는 자체 발전)' 전력을 추구하고 있습니다. 성장을 제약할 수 있는 가장 큰 병목 현상, 가장 걱정되는 한 가지는 무엇입니까? 전력인가요, 자금 조달인가요, 아니면 메모리나 파운드리 같은 다른 것인가요? 감사합니다.

Jensen Huang (CEO) 0:52:15 이 모든 것이 이슈이고, 모든 것이 제약입니다. 이유는 우리가 성장하고 있는 속도와 규모로 볼 때, 쉬운 게 하나라도 있을 수 있겠습니까? 엔비디아가 하고 있는 일은 분명 이전에 한 번도 행해진 적이 없는 일입니다. 우리는 완전히 새로운 산업을 창출했습니다. 한편으로는 컴퓨팅을 범용 및 고전/전통적 컴퓨팅에서 가속 컴퓨팅과 AI로 전환하고 있습니다. 다른 한편으로는 'AI 공장(AI factories)'이라는 완전히 새로운 산업을 만들었습니다. 소프트웨어가 실행되기 위해 미리 만들어진 정보를 검색하는 대신, 모든 토큰을 생성하는 이 공장들이 필요하다는 아이디어 말입니다. 이 모든 전환은 엄청난 규모를 요구합니다. 공급망의 경우, 우리는 공급망 관리에 매우 능숙하기 때문에 가시성과 통제력이 훨씬 좋습니다. 우리는 33년 동안 함께해 온 훌륭한 파트너들이 있습니다. 공급망 부분은 꽤 자신 있습니다. 이제 공급망 아래를 보면, 우리는 토지, 전력, 쉘(건물), 그리고 물론 자금 조달 분야의 수많은 플레이어들과 파트너십을 맺었습니다. 이 중 어느 것도 쉽지 않지만, 모두 다룰 수 있고 해결 가능한 문제들입니다. 우리가 해야 할 가장 중요한 일은 계획을 잘 세우는 것입니다. 우리는 공급망 상류와 하류 모두를 계획합니다. 우리는 수많은 파트너를 확보했습니다. 시장으로 가는 경로(routes to market)도 많습니다. 매우 중요하게도, 우리의 아키텍처는 고객에게 최고의 가치를 제공해야 합니다. 현시점에서 저는 엔비디아의 아키텍처가 최고의 TCO(총소유비용) 대비 성능을 제공한다고 확신합니다. 그것은 최고의 와트당 성능이며, 따라서 전달되는 에너지의 양에 대해 우리 아키텍처가 가장 많은 매출을 창출할 것입니다. 우리의 성공 속도가 빨라지고 있고, 작년 이맘때보다 지금 우리가 더 성공적이라고 생각합니다. 다른 대안을 탐색한 후 우리에게 오는 고객과 플랫폼의 수가 줄어드는 게 아니라 늘어나고 있습니다. 수년간 제가 여러분께 말씀드려온 모든 것들이 정말로 실현되고 명백해지고 있다고 생각합니다.

Operator 0:54:58 다음 질문은 Bernstein Research의 Stacy Rasgon 님입니다. 연결되었습니다.

Stacy Rasgon (Bernstein Research) 0:55:09 질문이 있습니다. Colette 님, 마진에 대해 질문이 있습니다. 내년에 70% 중반대(mid-70s) 유지를 위해 노력하겠다고 하셨는데요. 가장 큰 비용 증가 요인은 무엇입니까? 단순히 메모리인가요, 아니면 다른 것인가요? 이를 위해 어떤 노력을 하고 계신가요? 비용 최적화 대 선구매(pre-buys) 대 가격 책정의 비중은 어느 정도인가요? 또한 현재 수준에서 매출이 실질적으로 성장할 것으로 보이는 상황에서 내년 운영비용(OpEx) 증가는 어떻게 생각해야 할까요?

Colette Kress (EVP and CFO) 0:55:44 감사합니다, Stacy. 우리가 현재 회계연도에 어디에 있었는지 기억하는 것부터 시작하겠습니다. 기억하시겠지만, 올해 초 우리는 비용 개선과 믹스를 통해 연말에 총마진 70% 중반대로 마감하겠다고 밝혔습니다. 우리는 그것을 달성했고, 4분기에도 이를 실행할 준비가 되어 있습니다. 이제 내년에 대해 우리가 어디서 작업하고 있는지 소통할 때입니다. 내년에는 업계에 잘 알려진 투입 가격(input prices) 상승 요인들이 있어 이를 해결해야 합니다. 우리 시스템은 다루기가 결코 쉽지 않습니다. 엄청난 양의 부품과 매우 다양한 부분들이 들어갑니다. 우리는 그 모든 것을 고려하고 있습니다. 비용 개선, 사이클 타임 단축, 믹스 개선 작업을 다시 진행하면서 총마진을 70% 중반대로 유지하기 위해 노력할 것입니다. 그것이 우리의 전반적인 총마진 계획입니다. 두 번째 질문은 OpEx에 관한 것이군요. 현재 OpEx 측면에서 우리의 목표는 엔지니어링 팀, 모든 비즈니스 팀과 함께 혁신하여 이 시장을 위한 더 많은 시스템을 만드는 것입니다. 아시다시피, 지금 새로운 아키텍처가 나오고 있습니다. 이는 그 목표를 달성하기 위해 그들이 꽤 바쁘다는 것을 의미합니다. 우리는 소프트웨어, 시스템, 하드웨어 모두를 혁신하기 위해 투자를 계속할 것입니다. 젠슨 님이 덧붙일 말씀이 있으시면 넘기겠습니다.

Jensen Huang (CEO) 0:57:29 네, 정확합니다. 제가 덧붙이자면, 우리는 공급망과 아주 오래전부터 예측하고, 계획하고, 협상한다는 점을 기억해 주십시오. 우리 공급망은 우리의 요구사항을 꽤 오랫동안 알고 있었습니다. 우리의 수요도 오랫동안 알고 있었고요. 우리는 그들과 꽤 오랫동안 협력하고 협상해 왔습니다. 최근의 급증세는 분명 상당히 큽니다. 하지만 우리 공급망은 우리와 아주 오랫동안 일해왔습니다. 많은 경우, 우리는 세계에서 가장 큰 회사와 일하고 있기 때문에 우리 자신을 위해 많은 공급을 확보했습니다. 우리는 또한 재무적인 측면에서도 그들과 긴밀히 협력하여 예측과 계획 등을 확보했습니다. 이 모든 것이 우리에게 잘 작동했다고 생각합니다.

Operator 0:58:25 마지막 질문은 Wells Fargo의 Aaron Rakers 님입니다. 연결되었습니다.

Aaron Rakers (Wells Fargo) 0:58:35 네, 질문 받아주셔서 감사합니다. 젠슨 님, 발표된 Anthropic 거래와 전반적인 고객의 폭을 고려할 때, 이러한 아키텍처 구축에서 AI ASIC이나 전용 XPU가 하는 역할에 대한 생각이 조금이라도 바뀌셨는지 궁금합니다. 과거에 이런 프로그램(자체 칩 개발 등) 중 일부는 실제로 배포되지 못한다고 꽤 단호하게 말씀하셨던 것 같은데요. 어쩌면 GPU 아키텍처 쪽으로 상황이 더 유리하게 바뀌었는지 궁금합니다. 감사합니다.

Jensen Huang (CEO) 0:59:10 정말 감사합니다. 질문 감사드립니다. 우선, 여러분은 칩과 경쟁하는 것이 아닙니다. 실례했습니다. 다시 말씀드리면, 회사로서 여러분은 '팀(teams)'과 경쟁하는 것입니다. 세상에 이렇게 엄청나게 복잡한 것을 구축하는 데 탁월한 팀은 그리 많지 않습니다. Hopper나 Ampere 시절에는 GPU 하나만 만들면 됐습니다. 그게 가속 AI 시스템의 정의였죠. 오늘날 우리는 전체 랙(rack)을 만들어야 하고, 세 가지 다른 유형의 스위치(스케일업, 스케일아웃, 스케일어크로스)를 만들어야 합니다. 컴퓨팅 노드를 구축하는 데 이제 칩 하나로는 어림도 없습니다. AI는 메모리가 필요하기 때문에 컴퓨팅 시스템의 모든 것이 달라졌습니다. 예전 AI는 메모리가 아예 없었죠. 이제는 기억해야 합니다. 메모리 양과 문맥(context)은 거대합니다. 메모리 아키텍처의 영향은 엄청납니다. 모델의 다양성도 전문가 혼합(Mixture of Experts)부터 밀집(Dense) 모델, 확산(Diffusion) 모델, 자기회귀(Autoregressive) 모델, 물리 법칙을 따르는 생물학적 모델까지 지난 몇 년간 폭발적으로 늘어났습니다. 과제는 문제의 복잡성이 훨씬 높다는 것입니다. AI 모델의 다양성이 믿을 수 없을 정도로 큽니다. 여기에 우리를 특별하게 만드는 5가지가 있습니다. 첫 번째는 우리가 그 전환의 모든 단계를 가속화한다는 것입니다. CUDA는 범용에서 가속 컴퓨팅으로의 전환을 위한 CUDA X를 제공합니다. 우리는 생성형 AI에 엄청나게 능숙합니다. 우리는 에이전트 AI에 엄청나게 능숙합니다. 그 전환의 모든 단계, 모든 레이어에서 우리는 탁월합니다. 하나의 아키텍처에 투자하여 전반적으로 사용할 수 있습니다. 하나의 아키텍처를 사용하며 그 세 단계에 걸친 워크로드 변화를 걱정할 필요가 없습니다. 그게 첫 번째입니다. 두 번째, 우리는 AI의 모든 단계(phase)에서 탁월합니다. 우리가 사전 학습(pretraining)에 강하다는 건 누구나 압니다. 사후 학습(post-training)도 당연히 아주 잘합니다. 그리고 밝혀진 바와 같이, 우리는 추론(inference)에서도 엄청나게 뛰어납니다. 추론은 정말, 정말 어렵기 때문입니다. 생각하는 게 어떻게 쉬울 수 있겠습니까? 사람들은 추론이 한 번에 끝나는(one shot) 것이라 쉽다고 생각합니다. 누구나 그런 식으로 시장에 접근할 수 있죠. 하지만 알고 보면 생각하는 것은 꽤 어렵기 때문에 추론이 가장 어렵습니다. 우리는 AI의 모든 단계에서 훌륭합니다. 이것이 두 번째입니다. 세 번째는 우리가 이제 모든 AI 모델, 모든 프론티어 AI 모델을 실행하는 세계 유일의 아키텍처라는 점입니다. 우리는 오픈소스 AI 모델을 믿을 수 없을 정도로 잘 실행합니다. 과학 모델, 생물학 모델, 로봇 공학 모델을 실행합니다. 모든 단일 모델을 실행합니다. 확산 기반이든 자기회귀든 상관없습니다. 우리는 모든 것을 실행합니다. 앞서 언급한 모든 주요 플랫폼을 위해 실행합니다. 네 번째는 우리가 모든 클라우드에 있다는 것입니다. 개발자들이 우리를 사랑하는 이유는 우리가 말 그대로 어디에나 있기 때문입니다. 모든 클라우드에 있습니다. 우리는 심지어 DGX Spark라는 아주 작은 클라우드도 만들어 드릴 수 있습니다. 우리는 모든 컴퓨터에 있습니다. 클라우드부터 온프레미스(사내 구축), 로봇 시스템, 엣지 디바이스, PC까지 어디에나 있습니다. 하나의 아키텍처로 모든 것이 작동합니다. 놀라운 일이죠. 마지막, 그리고 아마도 가장 중요한 다섯 번째는, 만약 당신이 클라우드 서비스 제공자(CSP)이거나, Humane, CoreWeave, NSCALE, Nevius, 혹은 OCI 같은 새로운 회사라면, 엔비디아가 최고의 플랫폼인 이유는 우리의 수요처(offtake, 물량을 받아주는 곳)가 매우 다양하기 때문입니다. 우리는 당신의 물량 소화를 도울 수 있습니다. 단순히 무작위 ASIC을 데이터센터에 넣는 게 중요한 게 아닙니다. 그 수요가 어디서 옵니까? 다양성은 어디서 옵니까? 회복 탄력성은 어디서 옵니까? 아키텍처의 다재다능함, 능력의 다양성은 어디서 옵니까? 엔비디아는 생태계가 워낙 크기 때문에 믿을 수 없을 정도로 좋은 수요처(offtake)를 가지고 있습니다. 그래서 이 5가지: 가속화와 전환의 모든 단계, AI의 모든 단계, 모든 모델, 모든 클라우드에서 온프레미스까지, 그리고 마지막으로 이 모든 것이 수요(offtake)로 이어진다는 점입니다.

Operator 1:03:51 감사합니다. 이제 마무리 발언을 위해 Toshiya Hari 님에게 마이크를 넘기겠습니다.

Toshiya Hari (VP of Investor Relations) 1:04:00 마무리하며, 12월 2일에 열리는 UBS 글로벌 기술 및 AI 컨퍼런스에 참석한다는 점을 알려드립니다. 그리고 2026 회계연도 4분기 실적을 논의하기 위한 어닝콜은 2월 25일로 예정되어 있습니다. 오늘 참여해 주셔서 감사합니다. 운영자님, 통화를 종료해 주십시오.

Operator 1:04:19 감사합니다. 이것으로 오늘의 컨퍼런스 콜을 마칩니다. 이제 연결을 끊으셔도 됩니다.

5. 핵심 인사이트

이번 NVAD의 실적은

최근 불거준 AI 거품론을 무색하게 만들만큼 좋았습니다.

그러나

실적발표 당일 주가는 5% 상승 출발에서 종가 3%하락으로

8%의 큰 변동성을 보여주었습니다.

그리고

현재도 NVDA의 주가는 고점 대비 -16% 지점에 있습니다.

AI 거품론/Gemini 3.0/순환 출자/자본 조달 등

다양한 이슈가 있지만

NVDA의 펀더멘털에는 문제가 없습니다.

장기투자자에게는 좋은 진입점이 될 수도 있을 것 같습니다..

주식 투자를 위한 정말 최소한의 투자 지식

1강.

주식 투자를 위한 필수 재무제표 지식

_Feat.Gemini를 통해 어려운 영어와 재무제표 용어 극복하기

https://ssam.teacherville.co.kr/ssam/contents/25901.edu

주식 투자를 위한 정말 최소한의 투자 지식

2강.

기업 분석의 실전! 3단계 프로세스

https://ssam.teacherville.co.kr/ssam/contents/26301.edu

권위있는 교사의 교사는 편안하고 학생은 안정감을 느끼는

학급경영 강의에

2시간을 투자하시고 수십 년의 교직생활을 편하게 보내시기 바랍니다.

https://ssam.teacherville.co.kr/ssam/contents/25691.edu